Harmoniser les outils

Pour ses 7 établissements d’enseignement supérieur, les universités de Rennes souhaitent qu’un seul outil de recherche documentaire soit proposé. Ce n’est, en effet, pas encore le cas : l’Université de Rennes 1, l’Université de Rennes 2, l’INSA Rennes, Sciences Po Rennes, l’École Nationale Supérieure de Chimie de Rennes (ENSCR), l’École Normale Supérieure de Rennes (ENS), et, enfin, l’École des Hautes Etudes en Santé Publique (EHESP) utilisent des outils différents pour accéder aux contenus de leur bibliothèque universitaire.

Cet outil de recherche documentaire, destiné à la fois aux étudiants, aux enseignants et aux bibliothécaires, sera à choisir parmi deux outils candidats, déjà utilisés par l’Université de Rennes 1 pour l’un et par l’Université de Rennes 2 pour l’autre.

Afin de les aider à sélectionner le meilleur service de recherche documentaire possible, les équipes des universités de Rennes nous ont confié une mission d’UX Research. Le point central de celle-ci : les tests utilisateurs.

Arbitrer grâce aux retours des utilisateurs

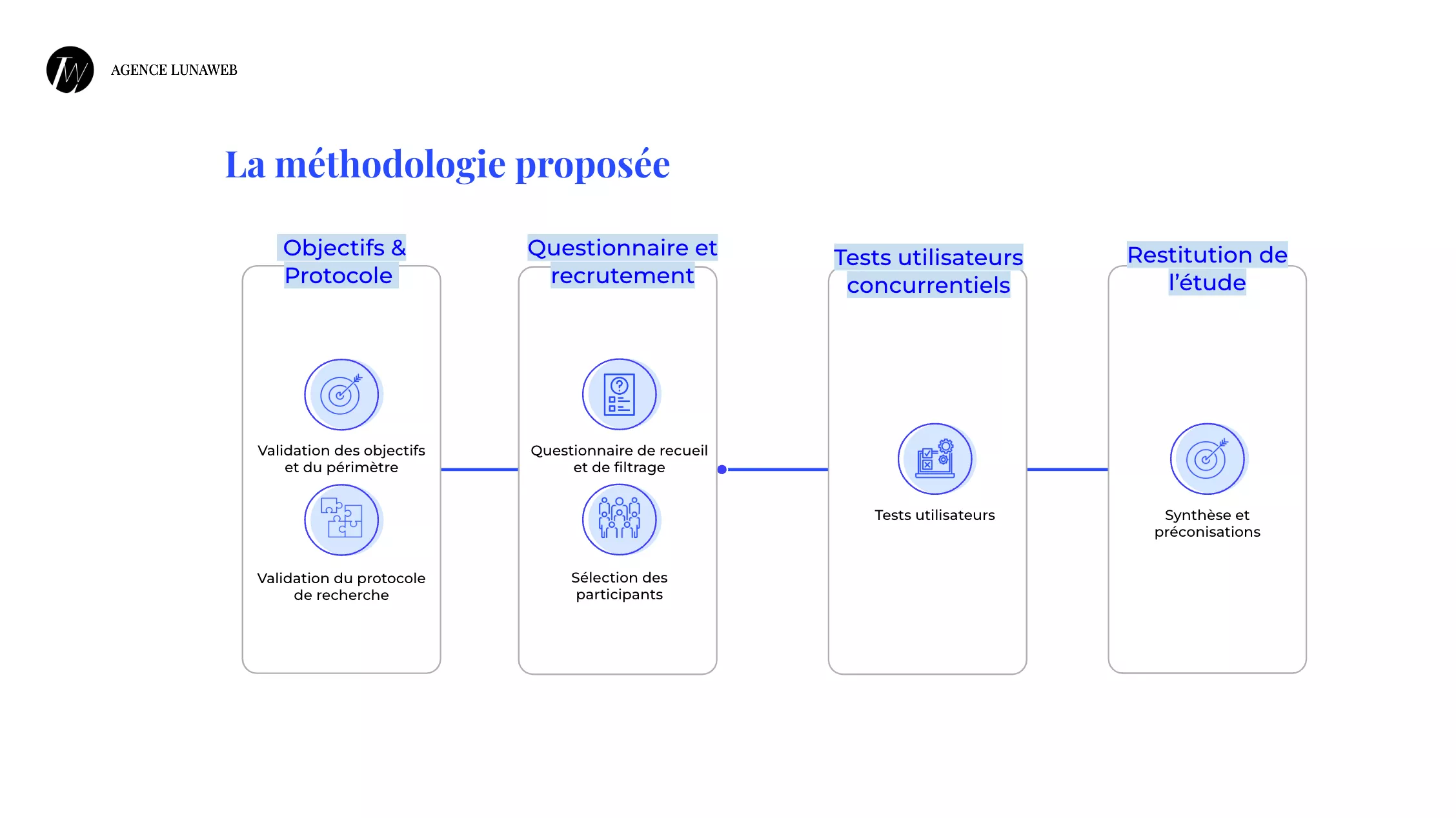

Dans le but de découvrir quel outil sur les deux semble offrir l’expérience utilisateurs la plus optimale, nous avons mis en place notre méthodologie bien ficelée de Recherche Utilisateurs. Anaïs, cheffe de projet, et Bérengère, accompagnée de Justine, UX Researchers, ont ainsi débuté le projet par la création et la diffusion d’un questionnaire de recueil et de recrutement. S’en est suivie une longue phase de tests utilisateurs comparatifs. En effet, Bérengère a rencontré pas moins de 22 personnes. Cela s’est conclu, comme toujours, par une analyse des données obtenues, aussi bien lors du questionnaire que des tests.

Tests utilisateurs et tests utilisateurs comparatifs, quelle différence ?

Le test utilisateur comparatif fonctionne comme un test utilisateur classique avec la particularité de faire reproduire deux fois le même scénario avec les mêmes tâches au testeur : une fois sur chacun des sites.

Cela permet d’obtenir exactement les mêmes types de données (temps de parcours, nombre d’erreurs, nombre d’échecs, résultats aux questionnaires, etc.) pour les deux interfaces et donc de réaliser un comparatif fiable.

Comparer l’UX en faisant parler les résultats

Protocole de Recherche Utilisateurs

Avant de lancer un projet d’UX Research, nous prenons toujours le temps de créer un protocole de recherche et de le faire valider auprès du client afin de s’assurer de mettre en place les méthodes les plus adaptées. C’était l’occasion pour les universités de Rennes de mentionner les points cruciaux sur lesquels nous devions nous attarder, mais aussi de s’accorder sur un objectif quantitatif d’obtention de réponses aux questionnaires et un nombre de tests utilisateurs à encadrer.

Questionnaire de recueil et de recrutement

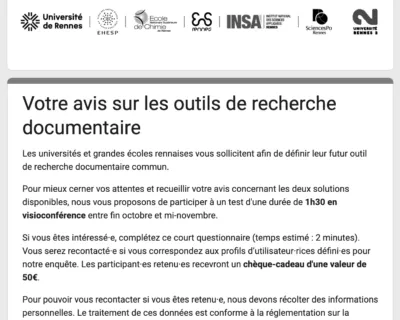

Début octobre 2023, nous partagions le questionnaire de recueil et de recrutement sur les sites des deux universités et dans des newsletters internes. Comprenant à peine une dizaine de questions, ce formulaire est le même pour les personnes rattachées à l’Université de Rennes et celles à l’Université de Rennes 2.

L’objectif était tout d’abord d’obtenir, par un large échantillon de personnes, un premier ressenti quant à l’usage de l’outil connu puis d’établir un bref comparatif des retours. Un certain nombre de questions sont également consacrées à mieux connaître le répondant pour savoir si son profil est intéressant pour le test utilisateur et lui proposer de se prêter à l’exercice contre une compensation. C’est pour cela que l’on parle d’un questionnaire de recrutement.

En trois semaines, le questionnaire a récolté plus de 100 réponses, permettant de planifier 22 tests utilisateurs.

Tests utilisateurs comparatifs

Le cœur du projet, c’est bien la phase de tests utilisateurs comparatifs, prise en charge par Bérengère.

Elle a donc pu faire tester les deux outils par 11 utilisateurs de l’un et 11 utilisateurs de l’autre. Dans les deux cas, les 11 utilisateurs incluaient 7 étudiants, 3 enseignants et 1 bibliothécaire.

Ces tests ont suivi un déroulé très précis, le temps d’une heure :

- déroulé des 5 scénarios d’usage et de leurs tâches sur l’outil A avec un questionnaire ASQ après chaque scénario et un questionnaire meCUE à la fin des scénarios,

- débriefing oral des points positifs et négatifs et des améliorations par rapport au premier outil,

- déroulé des 5 scénarios d’usage et de leurs tâches sur l’outil B avec un questionnaire ASQ après chaque scénario et un questionnaire meCUE à la fin des scénarios,

- débriefing oral des points positifs et négatifs et des améliorations suite au second test,

- comparaison entre les deux outils au travers d’un questionnaire dédié et d’un échange.

50% des participants ont débuté avec l’outil A quand l’autre moitié a débuté avec le test avec l’outil B. Cela permet de limiter un phénomène d’apprentissage.

Comme vous pouvez le voir sur l’image, le premier scénario comporte 3 tâches, le second en contient 2 et les trois scénarios restants ont des tâches uniques. Pour rappel, ce sont exactement les mêmes scénarios qui sont réalisés sur les deux outils, par chacun des utilisateurs.

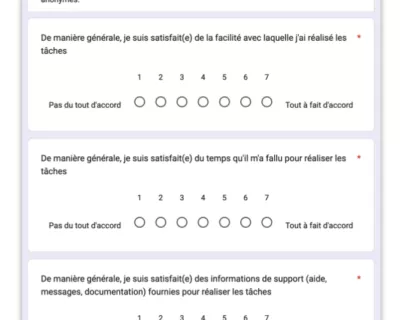

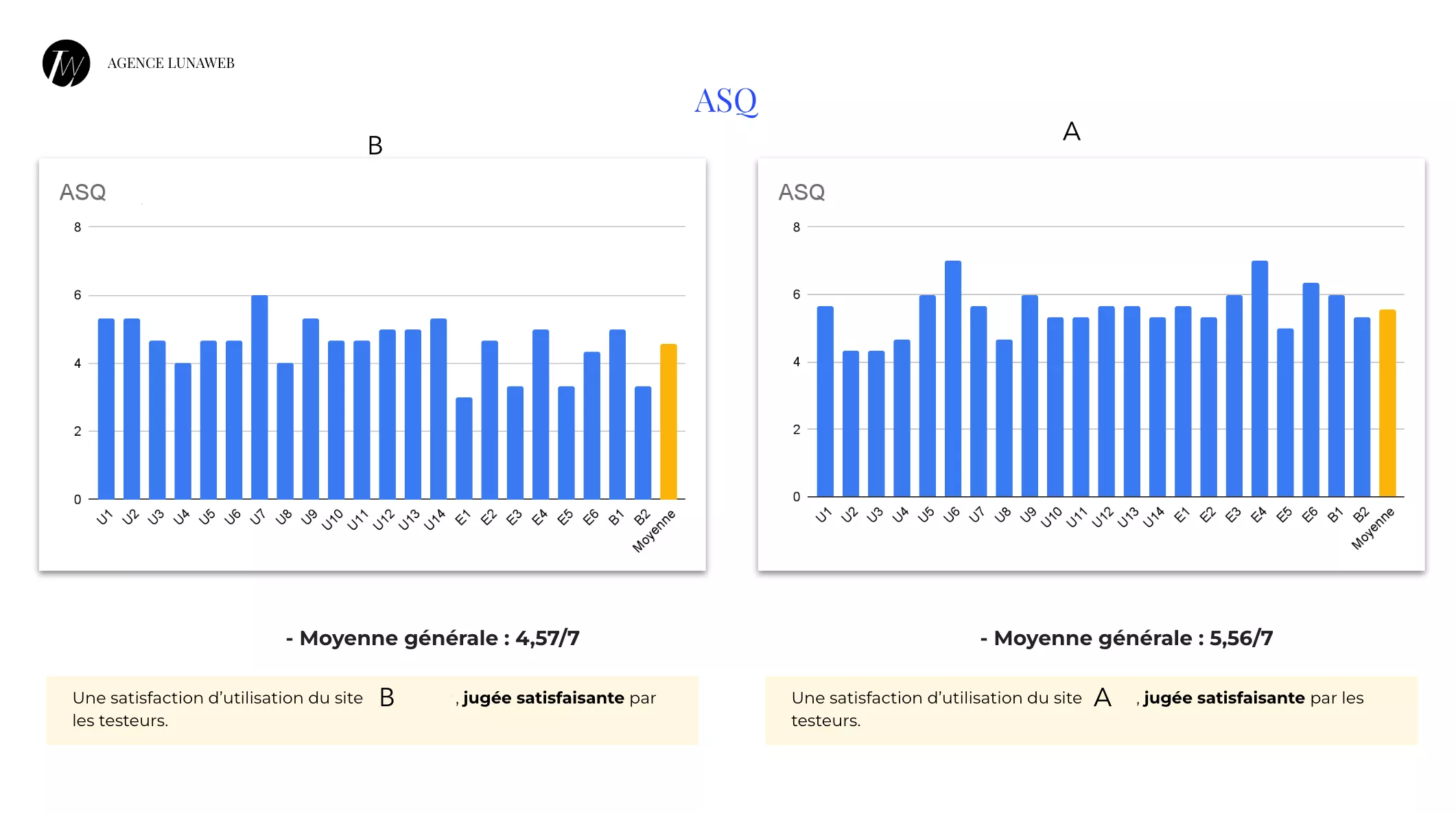

Un questionnaire ASQ, pour After Scenario Questionnaire, est une échelle de mesure de la satisfaction basée sur la norme ISO 9241-11 et selon 3 angles différents. Sur cette échelle, le “1” correspond à la réponse “Pas du tout d’accord” et le “7” correspond à “Tout à fait d’accord”.

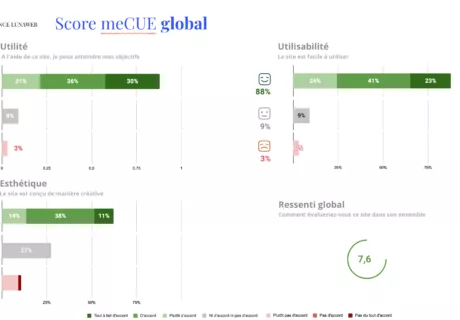

Un questionnaire meCUE (évaluation modulaire des composantes clés de l’expérience utilisateurs) permet notamment de mesurer l’utilité du site testé, son utilisabilité et son esthétisme. Il fournit des informations fiables sur la perception de l’interface puisque les questions se recoupent. Les réponses sont données au travers d’options telles que “Pas du tout d’accord” ; “Ni d’accord ni pas d’accord” ; “Tout à fait d’accord” par exemple).

Un livrable avec l’analyse des résultats

La phase d’analyse des résultats s’est en réalité déroulée en deux temps. Le premier dès le recueil des résultats au questionnaire. Il a permis de collecter des données quantitatives. Dans un second temps, Bérengère a analysé les résultats des tests utilisateurs comparatifs. Les données obtenues à cette étape sont à la fois quantitatives et qualitatives grâce à la mesure de :

- qualités hédoniques : elles mesurent le plaisir avant, pendant et après l’utilisation de l’outil,

- qualités pragmatiques : elles indiquent si l’outil est utile et facilement utilisable.

Les questionnaires ASQ et meCUE, utilisés dans notre projet, nous ont offert la possibilité de noter les deux outils selon les appréciations des utilisateurs. Ces notes ont pu confirmer que l’outil A sortait du lot. Avec une moyenne de 5,56/7 contre 4,57/7 aux questionnaires ASQ, l’outil A obtient un meilleur score que l’outil B.

Avec une moyenne de 7,6 contre 5,82, l’outil A obtient également un meilleur score que l’outil B pour les questionnaires meCUE.

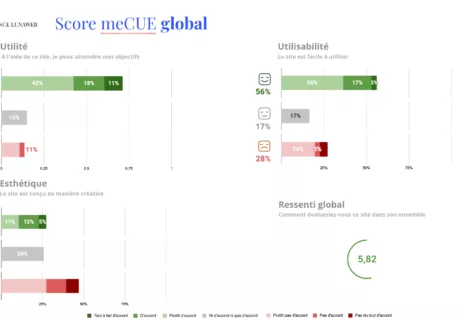

Bérengère a ensuite pris le temps d’analyser la réalisation des scénarios. En effet, pour chaque tâche, elle a chronométré l’utilisateur et noté ses échecs ou erreurs lorsqu’il y en avait.

Un comparatif entre les deux outils a été produit pour chaque scénario avec les temps de parcours et le nombre d’erreurs de chaque utilisateur. Encore une fois, sur la plupart des scénarios, c’est l’outil A qui l’emportait.

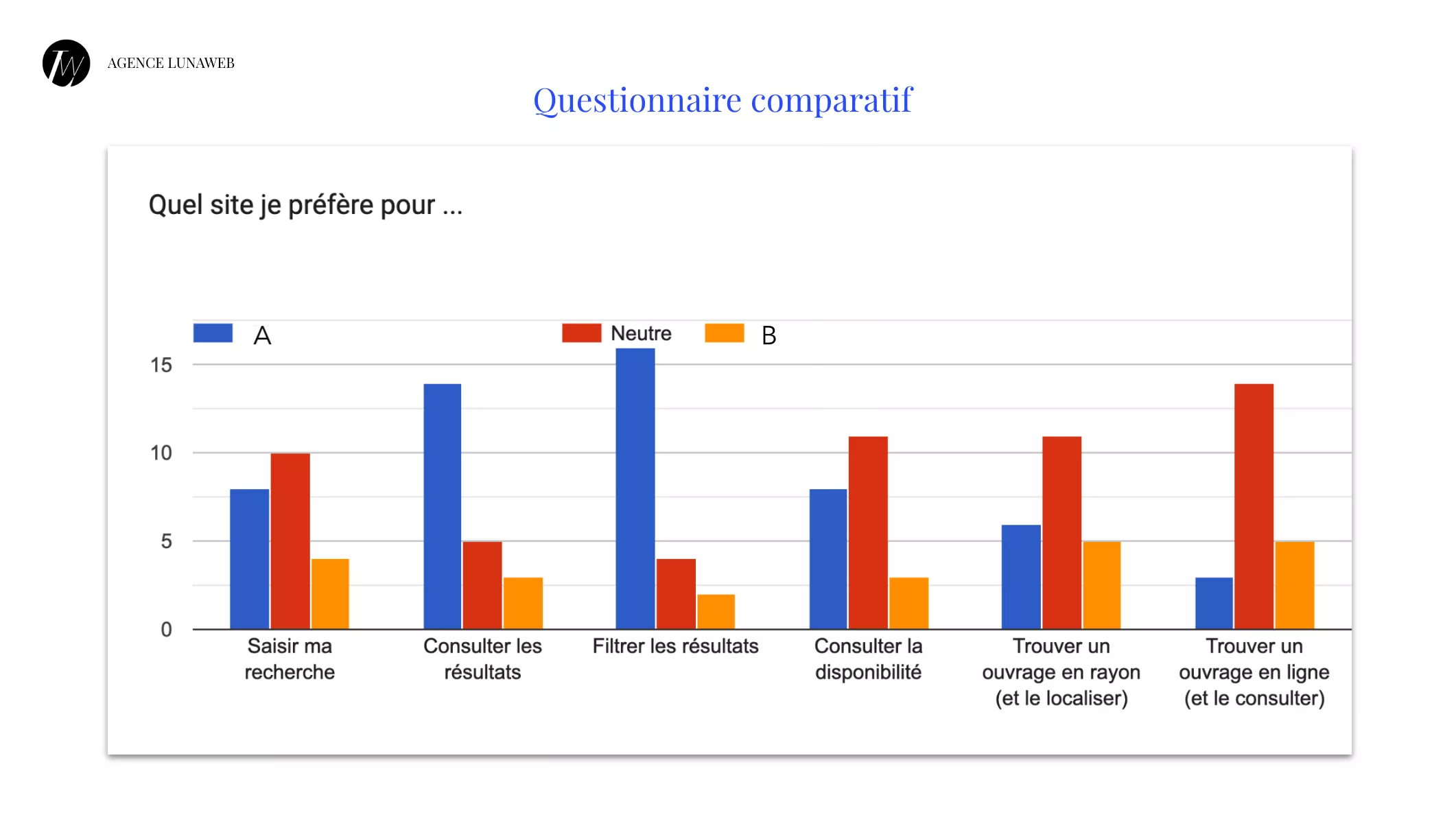

Elle a enfin analysé les résultats des questionnaires comparatifs, partagés en fin de test aux utilisateurs.

Le verdict est relativement clair puisque les différents points de comparaison ont démontré que l’outil A était plus fluide dans son utilisation et a offert une meilleure expérience utilisateurs aux testeurs que l’outil B.

Ces analyses ont finalement été synthétisées et réunies au sein d’un même document, le livrable qu’ont reçu les clients en fin de projet. Grâce à une restitution et à ce livrable de 290 pages, l’équipe des universités de Rennes est en mesure de comprendre quel outil semble être à privilégier d’un point de vue UX mais aussi pourquoi. Bérengère a également complété ce document par des recommandations à suivre pour améliorer l’outil de recherche documentaire proposé.

« Pour ce type de projet, la Recherche Utilisateurs est très importante : elle permet de contrebalancer des critères de décisions ultra rationnels tels que le prix. Cela équilibre la prise de décision pour ne pas seulement choisir des outils pour des critères de prix, mais aussi pour des critères d'expérience utilisateurs. »

Une piste de réflexion pour choisir le futur outil de recherche documentaire

Bien sûr, la qualité de l’expérience utilisateurs n’est pas le seul critère que prendront en compte les universités de Rennes pour choisir leur futur outil de recherche documentaire, mais les retours sont tels qu’il ne pourra pas être négligé non plus. Bérengère n’a d’ailleurs pas oublié de fournir des conseils pour faire face à la réfraction au changement.

En bref, c’est une affaire à suivre !